Stellen Sie sich vor ...

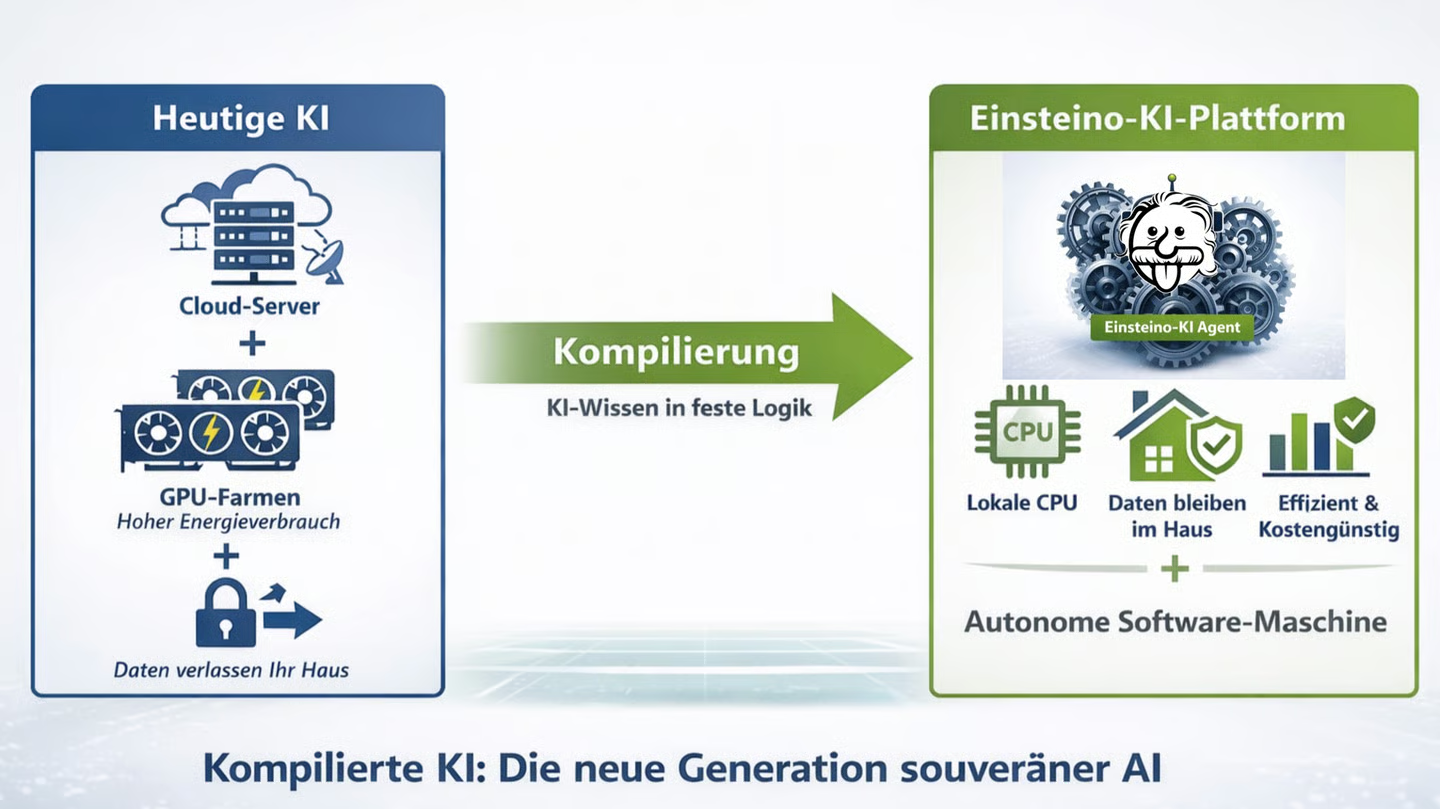

... heutige LLM - KI ist wie ein Professor in Übersee, den Sie für jede einzelne Antwort teuer per Satellit anrufen müssen. Das kostet viel Geld, verbraucht Unmengen an Strom und macht Sie völlig abhängig von der Leitung nach Amerika. Unser neues KI-Verfahren macht etwas völlig anderes: Wir lassen den Professor nicht die Arbeit machen, sondern wir lassen ihn ein perfektes Handbuch schreiben. Diesen Prozess nennen wir „Kompilieren": Wir verwandeln das flüchtige Wissen der KI in eine feste, logische Arbeitsanweisung. Das Ergebnis ist eine kleine, hochmoderne Software-Maschine, die keinen Professor und keine Cloud mehr braucht. Sie läuft direkt auf Ihren vorhandenen, herkömmlichen Büro-Rechnern (CPUs), statt auf teuren Spezial-Chips (GPUs). Dadurch sinken Ihre laufenden Kosten drastisch, da Sie keine „Miete" mehr für Rechenpower zahlen müssen. Ihre Daten verlassen niemals Ihr Haus, weil die Intelligenz nun fest in Ihren eigenen Geräten eingebaut ist. Unser neues Verfahren macht KI also von einer teuren Dienstleistung zu einem festen Werkzeug, das Ihnen als Unternehmen ganz allein gehört. Es ist deutsche Ingenieurskunst, die aus vager KI-Sprache präzise, effiziente und sichere Industrie-Logik macht. Powered by …

Cogniologic GmbH Berlin

Die Cogniologic GmbH mit Sitz in Berlin bietet bisher mit Einsteino klassisch LLM-basierte KI-Agenten im Gesundheitswesen an und arbeitet seit mehreren Jahren mit einem interdisziplinären Team an der Lösung eines der zentralen Probleme der Informatik = der direkten Transformation von menschlichem Wissen in ausführbare, verlässliche Logik.

Mit einem patentrechtlich geschützten Verfahren ist der Cogniologic GmbH Anfang 2025 etwas gelungen, das sich fundamental von heutigen neuronalen Netzen und Large Language Models unterscheidet. Es ermöglicht, KI-Wissen gezielt zu kompilieren in deterministische, kompakte und energieeffiziente Software-Maschinen, die lokal betrieben werden können.

Technologische Basis dafür ist eine industriell multipel einsetzbare Einsteino-Plattform, die wir 2026 bauen wollen. Diese erzeugt neuartige, autonom handelnde Einsteino-KI Agenten, die Large Language Models ausschließlich zum Lernen und zur Supervision nutzen. Später, im operativen Betrieb, überall in Industrie, Handel und Dienstleistung, arbeiten die neuartigen Einsteino-KI Agenten stabil, sicher und LLM-unabhängig – und greifen nur bei neuen uneindeutigen Situationen auf externe KI-Unterstützung zurück.

Der Vorteil: Im Betrieb sinken je nach Use Case Rechenzeit und Energieverbrauch drastisch, bei weniger Cloud-Abhängigkeit und regulatorischen Risiken.

Erste Plattform-Komponenten sind in der Entwicklung. Der Fokus liegt 2026 auf der Fertigstellung der Einsteino-Plattform und der skalierbaren Markteinführung. Die Cogniologic GmbH befindet sich damit in der Late-Seed-Phase mit Übergang zur Series A und will mit Investoren und Partnern eine glänzende Zukunft für KI made in Germany gestalten.